# 項目介紹

本項目是一個語音情感識別項目,支持多種預處理方法和模型。

源碼地址:SpeechEmotionRecognition-Pytorch

使用準備¶

- Anaconda 3

- Python 3.11

- Pytorch 2.2.1

- Windows 11 or Ubuntu 22.04

模型測試表¶

| 模型 | Params(M) | 預處理方法 | 數據集 | 類別數量 | 準確率 |

|---|---|---|---|---|---|

| BiLSTM | 2.10 | Emotion2Vec | RAVDESS | 8 | 0.85333 |

| BiLSTM | 1.87 | CustomFeature | RAVDESS | 8 | 0.68666 |

| BaseModel | 0.19 | Emotion2Vec | RAVDESS | 8 | 0.85333 |

| BaseModel | 0.08 | CustomFeature | RAVDESS | 8 | 0.68000 |

| BiLSTM | 2.10 | Emotion2Vec | 更大數據集 | 9 | 0.91826 |

| BiLSTM | 1.87 | CustomFeature | 更大數據集 | 9 | 0.90817 |

| BaseModel | 0.19 | Emotion2Vec | 更大數據集 | 9 | 0.92870 |

| BaseModel | 0.08 | CustomFeature | 更大數據集 | 9 | 0.91026 |

說明:

1. RAVDESS數據集只使用Audio_Speech_Actors_01-24.zip

2. 更大數據集數據集有近2.5萬條數據,做了數據量均衡的,知識星球也提供了該數據集的特徵數據。

安裝環境¶

- 首先安裝的是Pytorch的GPU版本,如果已經安裝過了,請跳過。

conda install pytorch==2.2.1 torchvision==0.17.1 torchaudio==2.2.1 pytorch-cuda=11.8 -c pytorch -c nvidia

- 安裝mser庫。

使用pip安裝,命令如下:

python -m pip install mser -U -i https://pypi.tuna.tsinghua.edu.cn/simple

建議源碼安裝,源碼安裝能保證使用最新代碼。

git clone https://github.com/yeyupiaoling/SpeechEmotionRecognition-Pytorch.git

cd SpeechEmotionRecognition-Pytorch/

python setup.py install

快速使用¶

在使用時只需要設置--use_ms_model=iic/emotion2vec_plus_base參數和音頻路徑即可。

python infer.py --audio_path=dataset/test.wav --use_ms_model=iic/emotion2vec_plus_base

輸出如下:

[2024-07-02 19:45:36.154355 INFO ] emotion2vec_predict:__init__:27 - 成功加載模型:models/iic/emotion2vec_plus_base

音頻:dataset/test.wav 的預測結果標籤爲:生氣,得分:1.0

準備數據¶

生成數據列表,用於下一步的讀取需要,項目默認提供一個數據集RAVDESS,這個數據集的介紹頁面,這個數據包含中性、平靜、快樂、悲傷、憤怒、恐懼、厭惡、驚訝八種情感,本項目只使用裏面的Audio_Speech_Actors_01-24.zip,數據集,說話的語句只有Kids are talking by the door和Dogs are sitting by the door,可以說這個訓練集是非常簡單的。下載這個數據集並解壓到dataset目錄下。

然後執行create_data.py裏面的create_ravdess_list('dataset/Audio_Speech_Actors_01-24', 'dataset')函數即可生成數據列表,同時也生成歸一化文件,具體看代碼。

python create_data.py

如果自定義數據集,可以按照下面格式,audio_path爲音頻文件路徑,用戶需要提前把音頻數據集存放在dataset/audio目錄下,每個文件夾存放一個類別的音頻數據,每條音頻數據長度在3秒左右,如 dataset/audio/angry/······。audio是數據列表存放的位置,生成的數據類別的格式爲 音頻路徑\t音頻對應的類別標籤,音頻路徑和標籤用製表符 \t分開。讀者也可以根據自己存放數據的方式修改以下函數。

執行create_data.py裏面的get_data_list('dataset/audios', 'dataset')函數即可生成數據列表,同時也生成歸一化文件,具體看代碼。

python create_data.py

生成的列表是長這樣的,前面是音頻的路徑,後面是該音頻對應的標籤,從0開始,路徑和標籤之間用\t隔開。

dataset/Audio_Speech_Actors_01-24/Actor_13/03-01-01-01-02-01-13.wav 0

dataset/Audio_Speech_Actors_01-24/Actor_01/03-01-02-01-01-01-01.wav 1

dataset/Audio_Speech_Actors_01-24/Actor_01/03-01-03-02-01-01-01.wav 2

注意: create_data.py裏面的create_standard('configs/bi_lstm.yml')函數必須要執行的,這個是生成歸一化的文件。

提取特徵(可選)¶

在訓練過程中,首先是要讀取音頻數據,然後提取特徵,最後再進行訓練。其中讀取音頻數據、提取特徵也是比較消耗時間的,所以我們可以選擇提前提取好取特徵,訓練模型的是就可以直接加載提取好的特徵,這樣訓練速度會更快。這個提取特徵是可選擇,如果沒有提取好的特徵,訓練模型的時候就會從讀取音頻數據,然後提取特徵開始。提取特徵步驟如下:

- 執行

extract_features.py,提取特徵,特徵會保存在dataset/features目錄下,並生成新的數據列表train_list_features.txt和test_list_features.txt。

python extract_features.py --configs=configs/bi_lstm.yml --save_dir=dataset/features

- 修改配置文件,將

dataset_conf.train_list和dataset_conf.test_list修改爲train_list_features.txt和test_list_features.txt。

訓練¶

接着就可以開始訓練模型了,創建 train.py。配置文件裏面的參數一般不需要修改,但是這幾個是需要根據自己實際的數據集進行調整的,首先最重要的就是分類大小dataset_conf.num_class,這個每個數據集的分類大小可能不一樣,根據自己的實際情況設定。然後是dataset_conf.batch_size,如果是顯存不夠的話,可以減小這個參數。

# 單卡訓練

CUDA_VISIBLE_DEVICES=0 python train.py

# 多卡訓練

CUDA_VISIBLE_DEVICES=0,1 torchrun --standalone --nnodes=1 --nproc_per_node=2 train.py

訓練輸出日誌:

[2024-02-03 15:09:26.166181 INFO ] utils:print_arguments:14 - ----------- 額外配置參數 -----------

[2024-02-03 15:09:26.166281 INFO ] utils:print_arguments:16 - configs: configs/bi_lstm.yml

[2024-02-03 15:09:26.166358 INFO ] utils:print_arguments:16 - local_rank: 0

[2024-02-03 15:09:26.166427 INFO ] utils:print_arguments:16 - pretrained_model: None

[2024-02-03 15:09:26.166494 INFO ] utils:print_arguments:16 - resume_model: None

[2024-02-03 15:09:26.166550 INFO ] utils:print_arguments:16 - save_model_path: models/

[2024-02-03 15:09:26.166613 INFO ] utils:print_arguments:16 - use_gpu: True

[2024-02-03 15:09:26.166676 INFO ] utils:print_arguments:17 - ------------------------------------------------

[2024-02-03 15:09:26.176508 INFO ] utils:print_arguments:19 - ----------- 配置文件參數 -----------

[2024-02-03 15:09:26.176604 INFO ] utils:print_arguments:22 - dataset_conf:

[2024-02-03 15:09:26.176673 INFO ] utils:print_arguments:25 - aug_conf:

[2024-02-03 15:09:26.176736 INFO ] utils:print_arguments:27 - noise_aug_prob: 0.2

[2024-02-03 15:09:26.176792 INFO ] utils:print_arguments:27 - noise_dir: dataset/noise

[2024-02-03 15:09:26.176861 INFO ] utils:print_arguments:27 - speed_perturb: True

[2024-02-03 15:09:26.176914 INFO ] utils:print_arguments:27 - volume_aug_prob: 0.2

[2024-02-03 15:09:26.176966 INFO ] utils:print_arguments:27 - volume_perturb: False

[2024-02-03 15:09:26.177017 INFO ] utils:print_arguments:25 - dataLoader:

[2024-02-03 15:09:26.177070 INFO ] utils:print_arguments:27 - batch_size: 32

[2024-02-03 15:09:26.177151 INFO ] utils:print_arguments:27 - num_workers: 4

[2024-02-03 15:09:26.177224 INFO ] utils:print_arguments:29 - do_vad: False

[2024-02-03 15:09:26.177275 INFO ] utils:print_arguments:25 - eval_conf:

[2024-02-03 15:09:26.177328 INFO ] utils:print_arguments:27 - batch_size: 1

[2024-02-03 15:09:26.177387 INFO ] utils:print_arguments:27 - max_duration: 3

[2024-02-03 15:09:26.177438 INFO ] utils:print_arguments:29 - label_list_path: dataset/label_list.txt

[2024-02-03 15:09:26.177489 INFO ] utils:print_arguments:29 - max_duration: 3

[2024-02-03 15:09:26.177542 INFO ] utils:print_arguments:29 - min_duration: 0.5

[2024-02-03 15:09:26.177593 INFO ] utils:print_arguments:29 - sample_rate: 16000

[2024-02-03 15:09:26.177647 INFO ] utils:print_arguments:29 - scaler_path: dataset/standard.m

[2024-02-03 15:09:26.177699 INFO ] utils:print_arguments:29 - target_dB: -20

[2024-02-03 15:09:26.177749 INFO ] utils:print_arguments:29 - test_list: dataset/test_list.txt

[2024-02-03 15:09:26.177800 INFO ] utils:print_arguments:29 - train_list: dataset/train_list.txt

[2024-02-03 15:09:26.177851 INFO ] utils:print_arguments:29 - use_dB_normalization: False

[2024-02-03 15:09:26.177905 INFO ] utils:print_arguments:22 - model_conf:

[2024-02-03 15:09:26.177959 INFO ] utils:print_arguments:29 - num_class: None

[2024-02-03 15:09:26.178011 INFO ] utils:print_arguments:22 - optimizer_conf:

[2024-02-03 15:09:26.178066 INFO ] utils:print_arguments:29 - learning_rate: 0.001

[2024-02-03 15:09:26.178118 INFO ] utils:print_arguments:29 - optimizer: Adam

[2024-02-03 15:09:26.178173 INFO ] utils:print_arguments:29 - scheduler: WarmupCosineSchedulerLR

[2024-02-03 15:09:26.178224 INFO ] utils:print_arguments:25 - scheduler_args:

[2024-02-03 15:09:26.178277 INFO ] utils:print_arguments:27 - max_lr: 0.001

[2024-02-03 15:09:26.178330 INFO ] utils:print_arguments:27 - min_lr: 1e-05

[2024-02-03 15:09:26.178381 INFO ] utils:print_arguments:27 - warmup_epoch: 5

[2024-02-03 15:09:26.178434 INFO ] utils:print_arguments:29 - weight_decay: 1e-06

[2024-02-03 15:09:26.178485 INFO ] utils:print_arguments:22 - preprocess_conf:

[2024-02-03 15:09:26.178537 INFO ] utils:print_arguments:29 - feature_method: Emotion2Vec

[2024-02-03 15:09:26.178588 INFO ] utils:print_arguments:25 - method_args:

[2024-02-03 15:09:26.178644 INFO ] utils:print_arguments:27 - granularity: utterance

[2024-02-03 15:09:26.178695 INFO ] utils:print_arguments:22 - train_conf:

[2024-02-03 15:09:26.178748 INFO ] utils:print_arguments:29 - enable_amp: False

[2024-02-03 15:09:26.178800 INFO ] utils:print_arguments:29 - log_interval: 10

[2024-02-03 15:09:26.178852 INFO ] utils:print_arguments:29 - loss_weight: None

[2024-02-03 15:09:26.178906 INFO ] utils:print_arguments:29 - max_epoch: 60

[2024-02-03 15:09:26.178957 INFO ] utils:print_arguments:29 - use_compile: False

[2024-02-03 15:09:26.179008 INFO ] utils:print_arguments:31 - use_model: BiLSTM

[2024-02-03 15:09:26.179059 INFO ] utils:print_arguments:32 - ------------------------------------------------

[2024-02-03 15:09:26.179184 WARNING] trainer:__init__:69 - Emotion2Vec特徵提取方法不支持多線程,已自動使用單線程提取特徵!

[2024-02-03 15:09:26.198994 INFO ] featurizer:__init__:23 - 使用的特徵方法爲 Emotion2Vec

==========================================================================================

Layer (type:depth-idx) Output Shape Param #

==========================================================================================

BiLSTM [1, 8] --

├─Linear: 1-1 [1, 512] 393,728

├─LSTM: 1-2 [1, 1, 512] 1,576,960

├─Tanh: 1-3 [1, 512] --

├─Dropout: 1-4 [1, 512] --

├─Linear: 1-5 [1, 256] 131,328

├─ReLU: 1-6 [1, 256] --

├─Linear: 1-7 [1, 8] 2,056

==========================================================================================

Total params: 2,104,072

Trainable params: 2,104,072

Non-trainable params: 0

Total mult-adds (Units.MEGABYTES): 2.10

==========================================================================================

Input size (MB): 0.00

Forward/backward pass size (MB): 0.01

Params size (MB): 8.42

Estimated Total Size (MB): 8.43

==========================================================================================

[2024-02-05 15:09:31.551738 INFO ] trainer:train:378 - 訓練數據:4407

[2024-02-05 15:09:32.951738 INFO ] trainer:__train_epoch:362 - Train epoch: [1/60], batch: [0/41], loss: 2.07688, accuracy: 0.15625, learning rate: 0.00001000, speed: 5.35 data/sec, eta: 4:05:18

[2024-02-05 15:09:56.525906 INFO ] trainer:__train_epoch:362 - Train epoch: [1/60], batch: [10/41], loss: 2.05963, accuracy: 0.22187, learning rate: 0.00005829, speed: 13.57 data/sec, eta: 1:36:15

····················

評估¶

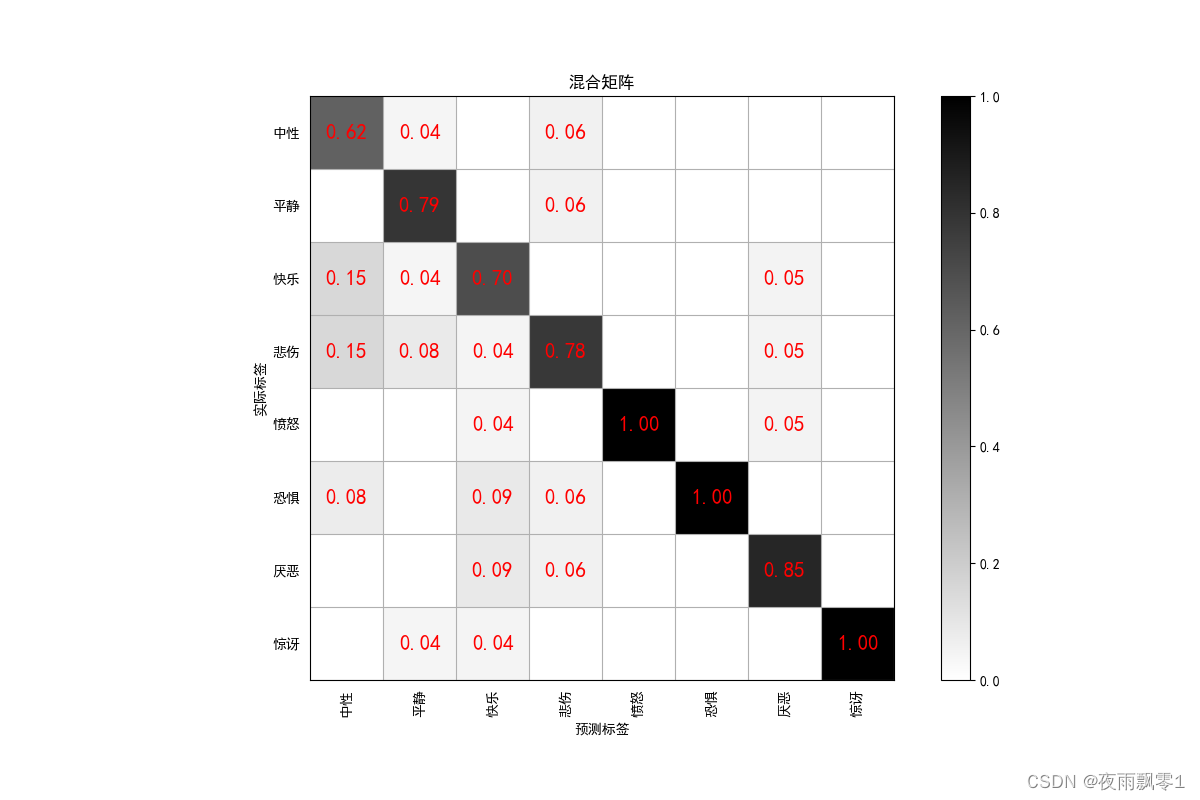

每輪訓練結束可以執行評估,評估會出來輸出準確率,還保存了混合矩陣圖片,保存路徑output/images/,如下。

python eval.py --configs=configs/bi_lstm.yml

評估輸出如下:

[2024-02-03 15:13:25.469242 INFO ] trainer:evaluate:461 - 成功加載模型:models/BiLSTM_Emotion2Vec/best_model/model.pth

100%|██████████████████████████████| 150/150 [00:00<00:00, 1281.96it/s]

評估消耗時間:1s,loss:0.61840,accuracy:0.87333

注意:如果類別標籤是中文的,需要設置安裝字體才能正常顯示,一般情況下Windows無需安裝,Ubuntu需要安裝。如果Windows確實是確實字體,只需要字體文件這裏下載.ttf格式的文件,複製到C:\Windows\Fonts即可。Ubuntu系統操作如下。

- 安裝字體

git clone https://github.com/tracyone/program_font && cd program_font && ./install.sh

- 執行下面Python代碼

import matplotlib

import shutil

import os

path = matplotlib.matplotlib_fname()

path = path.replace('matplotlibrc', 'fonts/ttf/')

print(path)

shutil.copy('/usr/share/fonts/MyFonts/simhei.ttf', path)

user_dir = os.path.expanduser('~')

shutil.rmtree(f'{user_dir}/.cache/matplotlib', ignore_errors=True)

預測¶

在訓練結束之後,我們得到了一個模型參數文件,我們使用這個模型預測音頻。

python infer.py --audio_path=dataset/test.wav

輸出如下:

成功加載模型參數:models/BiLSTM_Emotion2Vec/best_model/model.pth

[2024-07-02 19:48:42.864262 INFO ] emotion2vec_predict:__init__:27 - 成功加載模型:models/iic/emotion2vec_base

音頻:dataset/test.wav 的預測結果標籤爲:angry,得分:0.99995

使用Emotion2vec模型預測¶

項目已經提供了Emotion2vec模型,使用ModelScope公開的Emotion2vec模型預測音頻。在使用時只需要設置--use_ms_model參數即可,不需要額外配置文件和指定模型路徑,首次使用時會自動下載模型文件。支持iic/emotion2vec_plus_seed、iic/emotion2vec_plus_base、iic/emotion2vec_plus_large三個模型。

python infer.py --audio_path=dataset/test.wav --use_ms_model=iic/emotion2vec_plus_base

輸出如下:

[2024-07-02 19:45:36.154355 INFO ] emotion2vec_predict:__init__:27 - 成功加載模型:models/iic/emotion2vec_plus_base

音頻:dataset/test.wav 的預測結果標籤爲:生氣,得分:1.0

參考資料¶

- https://github.com/yeyupiaoling/AudioClassification-Pytorch

- https://github.com/alibaba-damo-academy/FunASR